Ein Bild als Objekt zu definieren ist seit den Diskussionen über moderne Malerei in der Kunstgeschichte kein Novum mehr. Folgt man den Ausführungen Lew Manovichs, einem der derzeit angesagtesten Medienwissenschaftler (und Kunsthistoriker), soll dem Wort „Objekt“ in der Kunstgeschichte eine neue Bedeutung zukommen. In seinem Artikel „Data Science and Digital Art History“1 von 2015 versucht er, skeptische FachkollegInnen von neuen Methoden der quantitativen Bildanalyse zu überzeugen. Während KunsthistorikerInnen bisher aufgrund ihrer biologisch determinierten, kognitiven Fähigkeiten nur einen bestimmten, eingeschränkten Bilderkanon hätten bearbeiten können, so Manovich, sollen durch die digitale Datenverarbeitung größere Bildmengen erschlossen werden.2 Er ist der Überzeugung, die verbreitete Methode des Bildvergleichs durch die quantitative Bildanalyse erweitern zu können, indem die KunsthistorikerInnen mit dem Computer „sehen“ lernen sollen.

Bei der quantitativen Bildanalyse werden Bilder als Datensätze erfasst und als „Objekte“ (objects) mit bestimmten Eigenschaften (features) definiert. Anhand dieser Eigenschaften ordnet eine Software die „Objekte“ in einem „Datenraum“ (feature space) an. Ähnlich den KunstwissenschaftlerInnen, so Manovich, gleicht die Software verschiedene Eigenschaften der Bilder ab. Die entstehende Bildkonstellation wird auf einem Bildfeld visualisiert, auf dem die Abbildung in miniaturisierter Form erscheinen. Unter Anwendung der „Principal Component Analysis“ erfasste Manovich beispielsweise „6000 Gemälde französischer Impressionisten“ (33), für deren Datensätze etwa 200 verschiedene Eigenschaften pro Bild extrahiert wurden, wie Farbcharakteristika, Kontrast, Formen, Texturen und bestimmte Kompositionsmerkmale. Das Ergebnis ist eine eindrucksvolle Bilderwolke in Form einer umgekehrten Parabel. Die miniaturartigen, bunten Reproduktionen der impressionistischen Gemälde erscheinen wie kleine Farbflecke vor dem „neutralen“ grauen Hintergrund des Datendiagramms und bilden eine Art Farbverlauf. Damit nähert sich die statistische Visualisierung auf eigentümliche Weise ihrem Untersuchungsgegenstand an – mehr als dem Erfinder lieb sein dürfte.

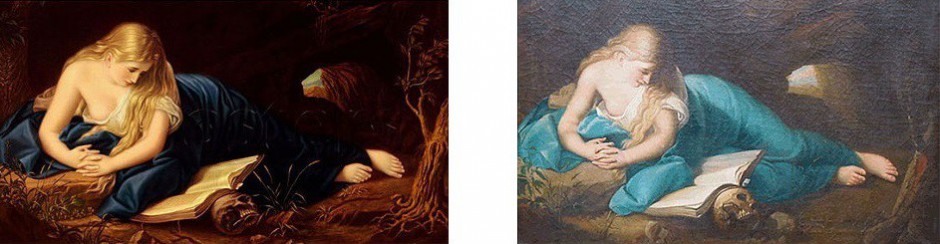

Manovich’s Bilderwolken sind eher ein anschauliches Beispiel für den derzeitigen Umgang mit Reproduktionen, als eine sinnvolle Grundlage kunstwissenschaftlicher Forschung. Ganz davon abgesehen, dass wohl niemand mehr sagen könnte, ob es sich bei den miniaturisierten Abbildungen tatsächlich um Reproduktionen impressionistischer Gemälde handelt oder nicht, lässt Manovich völlig unkommentiert, dass er sich bei seinem Forschungsansatz lediglich auf die Verarbeitung digitaler Reproduktionen von Kunstwerken stützt. Vor allem die Beurteilung der Farbwerte der Gemälde erscheint dabei fragwürdig. Außer der Feststellung, dass in etwa die Hälfte der Werke des „französischen Impressionismus“ aufgrund ihrer „dunkleren Farbtöne“ und „wärmeren Farben“ eher den „klassischen Gemälden des 19. Jahrhunderts“ entsprechen, bietet Manovich keine überzeugende Möglichkeit an, wie die Visualisierung zu deuten ist (33).

Wie Manovich selbst diskutiert, müssen bereits um die Datensätze der Bilder anzulegen vom Anwender Entscheidungen getroffen werden, die im kunsthistorischen Diskurs mitunter kontrovers wären: Welchen Umfang soll der beispielsweise der Datenbestand „französische Impressionisten“ haben? Welche „Objekte“ (also Bilder oder andere Dokumente, wie Briefkommunikation, Rezensionen) sind in die Datenerfassung einzubeziehen? Anhand welcher Eigenschaften sollen diese „Objekte“ erfasst werden? Wie mit der Unterschiedlichkeit der von Manovich genannten Quellen umgegangen werden soll, wird aber nicht erläutert. Auch die Verarbeitung raumgreifender Werke wäre für den Forschungsansatz mit Sicherheit eine Herausforderung.

Obwohl Manovich seinen Artikel an kunsthistorische Forscher richtet, scheint es ihm mehr um eine Erforschung allgemeiner, kultureller Entwicklungen zu gehen, als um kunstwissenschaftliches Arbeiten. An seinem methodisch etwas unscharfen Ansatz mag es auch liegen, dass er gerade in Beispielen, welche die Effektivität seiner Methode im kunsthistorischen Kontext demonstrieren sollen, nicht mit Reproduktionen von Kunstwerken argumentiert, sondern mit Fotografien aus Sozialen Medien oder aus dem Designbereich („photos shared on Instagram […] with a tag #fashion“, „differences in street fashion“, „landscape of current web design“(27)). Mit seiner Universalmethode lassen sich sowohl die Reproduktionen von Malereien als auch jegliche andere Art von Fotografien als „cutural artifacts“ (28) gleichermaßen untersuchen, da nur der Informationswert der Bilder im Vordergrund steht. Ohne den Ansatz in seinen Kinderschuhen grundsätzlich verwerfen zu wollen, müsste angesichts der genannten Problematiken jedoch deutlich gemacht werden, welchen zusätzlichen Erkenntnisgewinn die quantitative, digitale Auswertung reproduzierter Gemälde für die kunsthistorische Forschung haben könnte – außer, damit „anders“ zu sehen.4 Manovich hat darauf bisher keine Antwort gegeben.

1 Lew Manovich: Data Science and Digital Art History, in: International Journal fo Digital Art History (DAH), Ausgabe 1, 2015, S. 14-35. Artikel unter: http://manovich.net/index.php/projects/data-science, letzter Abruf: 24.11.2015.

2 „Art historians so far relied on human brain’s abilities that developed evolutionary to see patterns and understand similarity and difference between sets of artifacts. They seemed to do well without using mathematics, graphic methods, statistics, computation, or contemporary data science. But the price for this ’success‘ was the most extreme exclusion – considering only tiny sample of ‚important‘ or ‚best‘ works from every period or field.“ (27).

4„Using modern data analysis and visualization software, we can generate multiple views of the same data quickly and compare them. This helps us to expand our understanding of a cultural phenomenon, and also notice the relations and patterns we did not see before. In other words, data science allows us not only just to see the data that is too big for our unaided perception and cognition; it also allows us to see data of any size (including very familiar canonical cultural datasets) differently.“ (28-29).

My apologies for writing in English, hope its OK. If I understand Google automatic translation correctly, one question you address is the use of reproductions of artworks in digital art history. It is certainly an important topic. I often address it in my lectures, and I wrote a mini-article about it in 2010 – and included in ImagePlot documentation:

https://docs.google.com/document/d/1zkeik0v2LJmi1TOK4OxT7dVKJO7oCmx_fNP8SYdTG-U/edit?hl=en_US#bookmark=id.97zmsud3h3d3

Thank you for joining the discussion on our blog and pointing to your other studies about the image processing with ImagePlot. Indeed they answer some of my questions related to the use of digital reproductions of paintings that might be a problem, regarding colour hues for example. As you have shown, the deviation in saturation and brightness might not matter statistically comparing different digital reproductions from pictures of the same artist, depending on the questions that are to investigate.

Another concern that I still have in mind is, to what extend the results of the quantitative method using ImagePlot could be compared with or adjust art historical research, especially when dealing with qualitative values of paintings, like color hues.

Given that we accept the method works only with digital reproductions – despite some possible inacurateness – which benefit do we achieve by processing the images with a program instead of relying on human experience in our analysis (apart from beeing able to include a huge number of paintings)? Is there a benefit to take the mean value of saturation and other features to arrange the paintings, if we aim to assess how the pictures appear to humans who don’t operate with data sets while experiencing art?

Regarding your example of comparing the Van Gogh paintings done in Paris and in Arles by a representation in ImagePlot, for example. You found out, that the paintings don’t differ that much in the brightness and saturation values as art historical researchers suggested to assign the work of Van Gogh to different stylistic periods. But that are values ascertained by the software. Especially in Van Gogh’s work, the color effect on human vision, e.g. induced by the way he applied complementary colors, might be important for interpreting the works. It may influence the impression of how saturated or how bright the colors look, but it’s something that may not be captured by the statistical approach.

The representation of human experience and knowledge by using statisctics might have its own influences, difficulties and advantages, as well as the human vision itself has. What I’m asking is how the different approaches can be knit thogether to obtain fruitful results for art historical research.